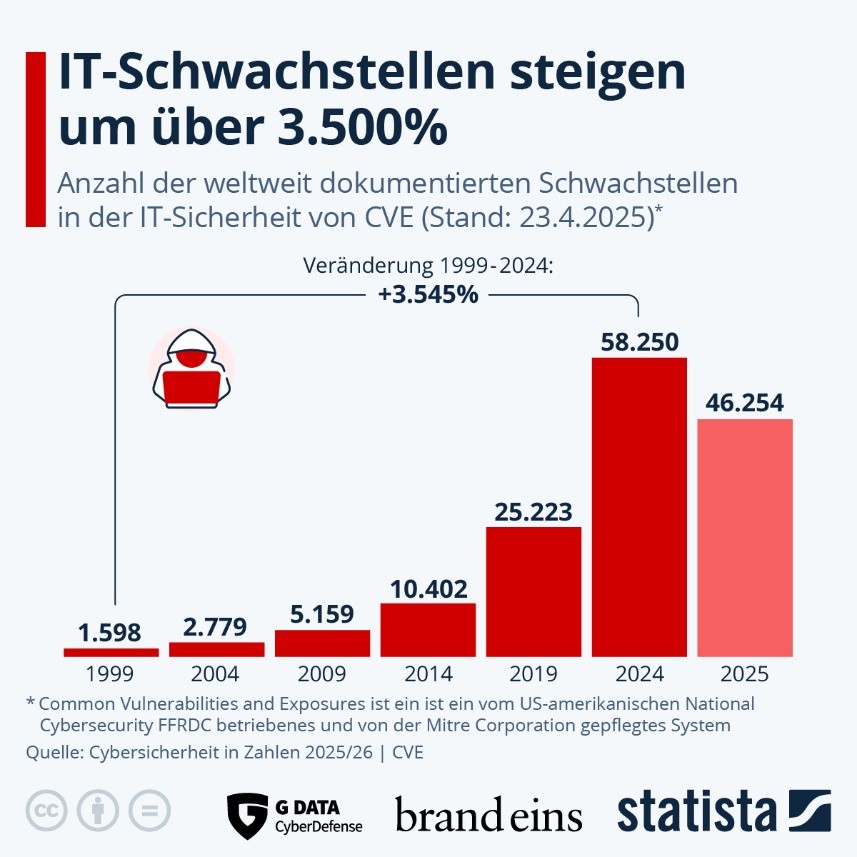

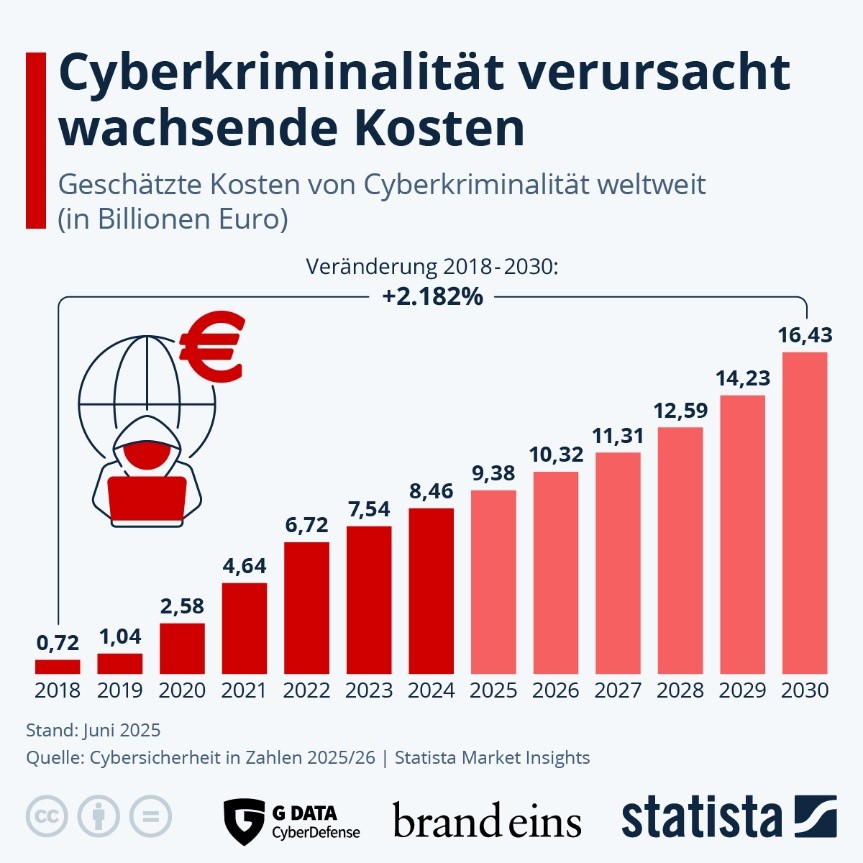

Cyberangriffe nehmen weltweit stetig zu. Zusätzlich steigt die Anzahl der Schwachstellen, die mit einer „Common Vulnerability and Exposure“ (CVE) versehen werden (vgl. Abbildung 1). Auch deutsche Unternehmen geraten zunehmend ins Visier von Hackern, sodass enorme finanzielle Schäden entstehen, die potenziell Betroffene in Handlungsnöte bringen (vgl. Abbildung 2). Der durch Cyberangriffe bei deutschen Unternehmen entstandene Schaden belief sich 2025 auf rund 289,2 Mrd. Euro, wie eine Studie von Bitkom (2025) zeigt. Befragt wurden dazu 1000 deutsche Unternehmen [1].

Abbildung 1: Wachstum von Schwachstellen mit CVE-Nummer (Quelle: Statista)

Demnach gewinnen Methoden wie das Threat Modeling an Bedeutung, um möglichen Schwachstellen und somit der Angriffsfläche entgegenzuwirken. Frameworks wie STRIDE helfen dabei, Bedrohungen systematisch zu identifizieren und zu kategorisieren [2]. Dennoch zeigt sich in der Praxis immer wieder, dass die Qualität der Analyse nicht nur von der Methode, sondern vor allem von den Menschen abhängt, die sie anwenden. Denn wo menschliche Entscheidungen eine Rolle spielen, treten oft kognitive Verzerrungen auf – unbewusste Denkmuster, die die Wahrnehmung und das Urteilsvermögen beeinflussen [3]. Dabei beschränkt sich der Einfluss kognitiver Verzerrungen nicht nur auf das Threat Modeling, sondern auf jeden Entscheidungsprozess des Menschen samt seiner vielfältigen Perspektiven. Insbesondere im Risikomanagement, das nicht nur essenziell in der Informationssicherheit ist, sind diese Verzerrungen im Blick zu halten, damit ihre Auswirkungen bewusst wahrgenommen und dementsprechende Entscheidungen angepasst werden. Dieser Artikel behandelt ausschließlich den Effekt kognitiver Verzerrungen auf das Threat Modeling. Die Erkenntnisse gelten auch für andere Entscheidungsprozesse, stehen hier aber nicht im Fokus.

In einer eigenen Untersuchung im Rahmen meines Bachelorstudiums im Fach Cyber Security zeigte sich, dass bereits ein thematischer Impuls, etwa ein Artikel zu Phishing, die STRIDE-Analyse von IT-Teams spürbar beeinflusst.

Zwar handelte es sich in meiner Arbeit um ein Experiment mit einer nicht-repräsentativen Anzahl an Teilnehmern, doch zeigte sich bereits im ersten Versuch, dass sich ein für mich als „Nichtpsychologe“ wahrnehmbarer Unterschied beider Test-Gruppen ergab.

Diese Beobachtung verweist auf eine zentrale und wichtige Fragestellung: Wie wirken kognitive Verzerrungen im Threat Modeling und welche Folgen ergeben sich daraus für die Praxis? Der vorliegende Artikel befasst sich mit mehreren kognitiven Verzerrungen und diskutiert, wie Unternehmen ihre Analysemethoden so gestalten können, dass menschliche Denkfallen abgefedert werden oder sich Chancen aus diesen Verzerrungen ergeben, die vorteilhaft für die Analyse sein könnten.

Threat Modeling und kognitive Verzerrungen

Threat Modeling ist ein zentraler Bestandteil moderner IT-Sicherheitsanalysen. Ziel ist es, potenzielle Bedrohungen frühzeitig zu identifizieren, ihre Eintrittswahrscheinlichkeit und ihre Auswirkungen abzuschätzen und Gegenmaßnahmen zu entwickeln. Threat Modeling umfasst die Analyse von Geschäftssystemen, Datenflüssen und Betriebsprozessen, um Schwachstellen aufzudecken[4]. Populäre Methoden wie STRIDE strukturieren diesen Prozess, indem sie Bedrohungen systematisch in Kategorien wie Spoofing, Tampering oder Repudiation einordnen. STRIDE selbst ist ein Akronym, das darüber hinaus auch Information Disclosure, Denial of Service und Escalation of Privileges miteinbezieht [5].

Auf diese Weise soll eine vollständige und möglichst objektive Sicht auf das Bedrohungsumfeld gewährleistet werden [5].

Doch so strukturiert dieser Ansatz auch ist, die Qualität der Analyse hängt stark von den beteiligten Personen ab [4]. Hier kommen kognitive Verzerrungen ins Spiel: Muster im Denken und Wahrnehmen, die jede menschliche Entscheidung prägen [3]. Sie beeinflussen, welche Informationen wir wahrnehmen, wie wir diese gewichten und welche Schlüsse wir daraus ziehen [6].

Abbildung 2: Wachstum und Prognose finanzieller Schäden von Cyberkriminalität (Quelle: Statista)

Grundsätzlich kann der Mensch keine vollständig objektive Realität erfassen. Unsere Wahrnehmung ist immer gefiltert durch Sinneseindrücke und die Verarbeitung im Gehirn. Dabei werden Informationen ergänzt, weggelassen oder insgesamt verzerrt, sodass eine scheinbar objektive Einschätzung in Wahrheit stets eine subjektive Konstruktion ist. Anders formuliert: Wir nehmen die Welt nicht so wahr, wie sie „ist“, sondern so, wie unser kognitives System sie uns zugänglich macht.

Übertragen wir das auf den Kontext des Threat Modeling, bedeutet das Folgendes: Analysten gehen nicht mit einem neutralen Blick an eine Analyse heran. Sie bringen Erwartungen, Erfahrungen, Denkmuster mit, die ihre Bewertungen beeinflussen. Ein aktuelles Bedrohungsszenario in den Medien kann dazu führen, dass genau diese Art von Angriff überbetont wird (Availability Bias). Anders könnten erste Hypothesen bestimmen, wie spätere Diskussionen geführt und welche Risiken bevorzugt betrachtet werden (Anchoring). Auch der Confirmation Bias, also die Tendenz, vor allem Belege für bereits bestehende Annahmen zu suchen, kann zu kognitiver Tunnel-Sicht führen.

Damit wird deutlich: Threat Modeling ist zwar eine methodisch fundierte Technik, bleibt aber anfällig für die psychologischen Grenzen menschlicher Wahrnehmung und Entscheidungsfindung.

Typische kognitive Verzerrungen im Threat Modeling

Threat Modeling soll ein rationaler und systematischer Prozess sein. Methoden wie STRIDE oder PASTA geben klare Kategorien und Abläufe vor. Sobald Menschen beteiligt sind, wirken psychologische Faktoren. Allen voran kognitive Verzerrungen. Diese sind keine Ausnahmeerscheinungen, sondern Teil unseres Denkens. Sie bestimmen, welche Bedrohungen wir zuerst sehen, welche wir für besonders wahrscheinlich halten und welche wir möglicherweise ganz übersehen. Im Folgenden werden zentrale Verzerrungen dargestellt, die für Threat-Modeling-Workshops von Bedeutung sein dürften.

- Primacy Effect

Menschen gewichten Informationen, die sie zuerst hören oder insgesamt wahrnehmen, stärker als solche, die später dazukommen. Im Threat Modeling kann das dazu führen, dass die zuerst genannte Bedrohung den weiteren Verlauf der Diskussion dominiert. Dadurch entsteht eine Tunnel-Sicht, in der spätere und möglicherweise wichtigere Angriffsvektoren weniger Beachtung finden. Gleichzeitig kann dieser Effekt jedoch gezielt genutzt werden: Wenn ein Moderator einen Workshop mit einem sicherheitskritischen Beispiel eröffnet, lässt sich so der Fokus auf besonders relevante Risiken lenken. - Availability Bias

Bedrohungen, die leicht ins Gedächtnis kommen, etwa weil sie in den Medien präsent waren oder im Unternehmen kürzlich aufgetreten sind, werden als wahrscheinlicher eingeschätzt, als sie es tatsächlich sind. In einem STRIDE-Workshop kann das bedeuten, dass Ransomware oder Phishing überproportional behandelt werden, während weniger offensichtliche Schwachstellen untergehen. Positiv betrachtet sorgt der Availability Bias dafür, dass Teams aktuelle Angriffstrends nicht ignorieren und schnell auf neue Bedrohungslagen reagieren können. - Anchoring Bias

Der Anchoring Bias beschreibt die Tendenz, sich bei Einschätzungen zu stark an einer anfänglichen Annahme oder Hypothese zu orientieren. Im Threat Modeling kann bereits die erste formulierte Bedrohung eine Art „Anker“ setzen, an dem sich die gesamte weitere Analyse orientiert. Dies kann zu einseitigen Ergebnissen führen, wenn der Anker falsch gewählt ist. Richtig eingesetzt, etwa durch eine bewusst gesetzte Einstiegsfrage, kann der Anker jedoch Struktur in die Diskussion bringen und den Fokus auf einen Angriffsvektor erhöhen. - Authority Bias

Dieser Bias beschreibt die Tendenz der Menschen, sich den Aussagen eines vermeintlichen Experten oder Fachmenschen anzuschließen. Ein solcher Fall kann den Vorteil fachlich heterogener Teams schwächen, da entgegengesetzte Meinungen unabhängig von ihrer Qualität aufgrund dieser Verzerrung unberücksichtigt bleiben könnten. - Groupthink

In interdisziplinären Teams besteht die Gefahr von Groupthink: Abweichende Meinungen werden nicht geäußert, weil man sich der Mehrheit oder dem vermeintlichen Experten (Authority Bias) anschließt. Dadurch gehen alternative Sichtweisen verloren, und die Analyse verliert an Breite. Groupthink kann den Prozess jedoch beschleunigen, da sich Gruppen schneller auf gemeinsame Ergebnisse einigen. - IKEA-Effekt

Dieser Effekt lässt sich beispielsweise an Möbeln zeigen, die man sich selbst zusammengebaut hat: Sie erhalten einen höheren Stellenwert als die, in die man keine Arbeit gesteckt hat. Möglicherweise gibt es hierbei eine Verzahnung mit der sog. Sunk-cost-Fallacy, einer Tendenz, an Entscheidungen aufgrund von Zeit, Kosten und Mühe festzuhalten, selbst wenn das nicht sinnvoll ist. Administratoren oder Entwickler, die an der Erstellung eines Systems mitgewirkt haben, stellen die Sicherheit des Systems weniger kritisch infrage – schließlich könnte das ein Indikator bereits investierter Expertise sein. Hierbei ist es wichtig, sich selbstreflektiert vor Augen zu führen, dass in jedem System Risiken stecken und es kein persönlicher Angriff auf die eigene Expertise ist, wenn das eigens entwickelte System kritisch infrage gestellt wird. Auch der zu leistende Aufwand in die Aufrüstung bestehender Systeme darf nicht verhindert werden, schließlich geht es um Arbeitsplätze und die Existenz des eigenen Unternehmens.

Die Liste kognitiver Verzerrungen ist nicht abschließend und reicht weit über die hier genannten Effekte hinaus. Sie werden trotz möglicher Relevanz in diesem Artikel nicht näher betrachtet.

Risiken für Threat Modeling und IT-Sicherheit

Kognitive Verzerrungen sind keine Randerscheinung und prägen jeden Schritt der Bedrohungsanalyse sowie Entscheidungsfindung [6]. Auch in systematischen Analyseprozessen stellt der Mensch das schwächste Glied der Kette dar. Die richtigen Einschätzungen erleichtern unseren Alltag sowie berufliche Entscheidungen, hinter denen meist enorme Summen stehen, die die Wirtschaftlichkeit von Unternehmen beeinflussen [7]. Übersehene Schwachstellen oder deren Fehleinschätzungen haben direkten Einfluss auf Personal, Kosten und insgesamt die Stabilität eines Unternehmens bzw. Systems.

Daher sollte sich ein Blick auf die Einschränkungen menschlicher Entscheidungen doch lohnen, oder?

Verzerrte Priorisierung von Bedrohungen

Sowohl Eintrittswahrscheinlichkeit als auch Schadensausmaß sind entscheidende Faktoren, wenn es um die Beurteilung von Schwachstellen eines Systems geht. Zwar gibt es in der quantitativen Analyse Herangehensweisen, die sich auf Zahlen und Formeln stützen. Dennoch verbleibt im qualitativen Bereich der Beurteilung von Schwachstellen ein erheblicher Anteil menschlicher Einschätzungen.

Noch vor der Beurteilung von Schwachstellen ist die Erkennung von Schwachstellen rein subjektiv und beruht auf der Ideenfindung und Kreativität der beteiligten Personen.

Somit bleiben sowohl qualitative Bedrohungsbeurteilung sowie Erkennung möglicher Bedrohungen im Auge des Betrachters, das dem menschlichen Empfinden unterliegt. Dies birgt Gefahren für die Priorisierung von Bedrohungen, für Fehleinschätzungen von Wahrscheinlichkeiten und Auswirkungen sowie für die Ideenvielfalt erkannter Bedrohungen. Auf diese wird nachfolgend näher eingegangen.

Biases wie der Availability Bias oder der Primacy Effect führen dazu, dass Teams bestimmte Angriffe überbewerten, weil sie derzeit präsent sind oder früh im Prozess erkannt wurden. Weniger auffällige, potenziell kritische Risiken geraten dadurch in den Hintergrund. So entsteht eine Scheinsicherheit, die Angreifern unentdeckte Einfallstore offenlässt.

Reduzierte Vielfalt der Szenarien

Verzerrungen wie Anchoring Bias oder Groupthink können dazu führen, dass die Diskussion schnell auf eine vermeintlich naheliegende Bedrohung verengt wird. Abweichende Meinungen werden kaum berücksichtigt, alternative Szenarien bleiben ungenannt. Statt einer breiten Analyse entsteht eine einseitige Betrachtung, die nur einen Bruchteil der tatsächlichen Angriffsvektoren abbildet.

Fehleinschätzungen von Wahrscheinlichkeiten und Auswirkungen

Durch den Optimism Bias neigen Organisationen dazu, Risiken für sich selbst als geringer einzustufen als für andere. In Kombination mit dem Overconfidence Bias entsteht daher das Bild einer vermeintlich robusten Sicherheitslage, auch wenn objektive Indikatoren Gegenteiliges nahelegen. Diese Fehleinschätzungen können dazu führen, dass Schutzmaßnahmen nicht konsequent umgesetzt oder priorisiert werden.

Retrospektive Verzerrungen

Der Hindsight Bias sorgt dafür, dass vergangene Angriffe im Nachhinein als „vorhersehbar“ erscheinen. Für künftige Analysen bedeutet das: Teams überschätzen ihre Fähigkeit, neue Bedrohungen zu erkennen, und unterschätzen gleichzeitig die Unsicherheit, die jede Prognose mit sich bringt. Dadurch werden aktuelle Analysen auf einen zu engen Erwartungskorridor reduziert.

Abhängigkeit von Autoritäten

In heterogenen Teams, wie sie für Threat Modeling typisch sind, spielt der Authority Bias eine größere Rolle. Aussagen von erfahrenen oder hierarchisch höhergestellten Personen dominieren die Diskussion, während Beiträge anderer Teammitglieder kaum Gewicht erhalten oder gar nicht erst zur Aussprache kommen. Das mindert die Qualität der Analyse, da wichtige Impulse aus anderen Perspektiven unterdrückt werden.

Potenziale kognitiver Verzerrungen

So problematisch kognitive Verzerrungen im Threat Modeling sein können, sie lassen sich nicht vollständig vermeiden. Jede Analyse ist ein Zusammenspiel aus rationaler Methode und subjektiver Wahrnehmung. Statt den Versuch zu unternehmen, Biases auszuschalten, bietet es sich an, ihre Dynamik bewusst als Werkzeuge einzusetzen, um Diskussionen zu strukturieren und Aufmerksamkeiten gezielt zu lenken.

Ein Potenzial liegt in der Fokussierung. Verzerrungen wie der Primacy oder Anchoring Effect können genutzt werden, um einen Workshop klar auszurichten. Wenn zu Beginn ein kritisches Angriffsszenario vorgestellt wird, dient dies als kognitiver „Startpunkt“, der die Teilnehmenden für dieses Risiko sensibilisiert. So kann der Moderator das Denken bewusst anstoßen, ohne den Prozess zu dominieren.

Ein weiteres Potenzial ergibt sich aus der Aktivierung von Erfahrungen. Menschen neigen dazu, Beispiele aus jüngster Vergangenheit oder persönlicher Praxis stärker einzubeziehen. Statt dies als Schwäche zu sehen, lässt sich der Effekt nutzen, indem aktuelle Fallstudien oder unternehmensinterne Vorfälle in den Workshop integriert werden. So entsteht eine Brücke zwischen abstrakten Bedrohungen und konkreten Handlungsfeldern, die das Bewusstsein im Team stärken.

Darüber hinaus können Biases gezielt als didaktisches Instrument eingesetzt werden. In Trainings- oder Awareness-Sessions lässt sich der Availability Bias bewusst provozieren, indem ein aktueller Angriff diskutiert wird, um Aufmerksamkeit für bestimmte Verteidigungsmaßnahmen zu schaffen. Der Lerneffekt ist höher, wenn die Teilnehmenden den Bezug nachvollziehen können.

Nicht zuletzt schaffen Verzerrungen auch Diskussionsdynamiken. Unterschiedliche Wahrnehmungen von Risiken regen zur Debatte an, vorausgesetzt, die Moderation stellt sicher, dass Meinungsunterschiede nicht unterdrückt, sondern produktiv genutzt werden. Gerade hier kann Groupthink durch gezieltes Gegenfragen aufgebrochen werden, sodass das Team nicht in Konsens verharrt, sondern Perspektivenvielfalt gewinnt.

Insgesamt zeigt sich: Kognitive Verzerrungen sind nicht nur eine Bedrohung für die Objektivität von Sicherheitsanalysen. Richtig verstanden und moderiert können sie ein Hebel sein, um Bedrohungsworkshops lebendiger, praxisnäher und nachhaltiger zu gestalten. Entscheidend ist ihre bewusste Integration in den Analyseprozess, da ein „Ausschalten“ ohnehin nicht möglich ist.

Strategien zum Umgang mit Verzerrungen

Die Herausforderung im Threat Modeling besteht nicht darin, kognitive Verzerrungen vollständig zu vermeiden, was ein aussichtsloses Unterfangen wäre, sondern darin, ihre Wirkung so zu gestalten, dass sie die Analyse nicht verfälschen und produktive Ergebnisse erzeugen können. Dazu lassen sich verschiedene Ansätze kombinieren, die methodische Strenge mit psychologischem Bewusstsein verbinden.

Ein erster Ansatz ist die strukturierte Moderation. Anstatt Diskussionen sich selbst zu überlassen, sollte eine neutrale Leitung bewusst dafür sorgen, dass unterschiedliche Sichtweisen eingebracht werden. Dies gelingt durch gezielte Nachfragen oder durch das bewusste Einfordern von Gegenargumenten sowie eine Sensibilisierung gegen vereinzelte Verzerrungen. So wird verhindert, dass sich das Team zu schnell auf ein dominantes Szenario einigt.

Ebenfalls wirkungsvoll ist die methodische Diversifizierung. Workshops profitieren davon, dass verschiedene Perspektiven systematisch eingenommen werden. Ein Beispiel ist die Rollenrotation: Jeder Teilnehmer betrachtet das System nacheinander aus Sicht unterschiedlicher STRIDE-Kategorien oder Angreiferprofile. Auf diese Weise wird die Aufmerksamkeit gezielt erweitert, anstatt sich nur auf naheliegende Szenarien zu beschränken.

Darüber hinaus können externe Referenzpunkte helfen, Verzerrungen abzufedern. Wenn die Ergebnisse eines Workshops regelmäßig mit etablierten Bedrohungskatalogen, wie den MITRE ATT&CK-Matrizes oder branchenspezifischen Vorfalls-Statistiken abgeglichen werden, lassen sich Lücken schneller erkennen. Diese Vergleiche schaffen eine Balance zwischen subjektiver Einschätzung und objektiven Referenzrahmen.

Ein weiterer Ansatz liegt in der Transparenz über Verzerrungen selbst. Teams, die sich der typischen Denkfallen bewusst sind, entwickeln eine stärkere Selbstkontrolle. Hier bieten sich kurze Awareness-Impulse an, die zu Beginn einer Sitzung durchgeführt werden. Es reicht gegebenenfalls ein Hinweis darauf, dass frühe Ideen das nachhaltige Denken prägen können oder aktuelle Medienberichte nicht zwingend die tatsächliche Risikolandschaft widerspiegeln. Bereits kleine Hinweise schaffen Sensibilität, ohne den Fluss der Analyse zu bremsen.

Schließlich spielt auch die Dokumentation eine zentrale Rolle. Wenn alle Gedankengänge, auch verworfene, festgehalten werden, entsteht ein Korrektiv gegen selektive Erinnerung. So lassen sich Entscheidungen später nachvollziehen, und es wird sichtbar, ob bestimmte Alternativen vorschnell ausgeschlossen wurden.

In Summe zeigt sich: Der wirksame Umgang mit kognitiven Verzerrungen erfordert kein radikal neues Threat-Modeling-Verfahren, sondern das bewusste Einweben psychologischer Reflexion in bestehende Methoden. Wer Biases kennt, kann sie nicht nur abmildern, sondern ihre Energie gezielt in die richtige Richtung lenken.

Nur stelle ich mir die Frage, wer bspw. für die Moderation am besten geeignet wäre: ein Psychologe mit ausgeprägtem Bewusstsein für kognitive Verzerrungen, welcher sprachlich in Gruppendynamiken gut bewandert ist, technisch nicht viel Ahnung von der Materie hat, oder ein technischer Fachmann, der sich gezielt mit dem eigenen Wissen aus der Diskussion herausnimmt und auf Basis seiner Erfahrung gezielte Impulse setzt, wenn bekannte Angriffsfelder unterrepräsentiert sind?

Fazit und Ausblick

Threat Modeling ist ein unverzichtbares Werkzeug, um komplexe IT-Systeme gegen Angriffe abzusichern. Doch es zeigt sich, dass nicht allein die Methode über die Qualität der Ergebnisse entscheidet, sondern auch die Art und Weise, wie Menschen Bedrohungen wahrnehmen und bewerten. Letztlich sind es Menschen, die anhand systematischer Konstrukte diese mit Leben füllen. Kognitive Verzerrungen sind dabei keine Nebensache, sondern ein zentraler Faktor, den es zu berücksichtigen gilt. Sie bestimmen, welche Szenarien den Weg in die Analyse finden, bestimmen die Gewichtung und dementsprechend auch die Risikobehandlung dieser Szenarien. Auch die Wahl geeigneter Gegenmaßnahmen ist unerlässlich, doch entscheidet sich die Eignung in der Priorität erkannter Schwachstellen. Bekanntlich gibt es kein System, das 100%-ige Sicherheit gewährleistet, also ist die Eignung eher als „wieviel Aufwand muss von Angreiferseite betrieben werden, um…“ zu betrachten.

Vollständige Objektivität ist in Bedrohungsanalysen illusorisch. Solange der Mensch zentraler Bestandteil eines Prozesses ist, sind dessen menschliche Schwächen miteinzubeziehen, die entweder abgefedert oder gezielt genutzt werden können. Dementsprechend sollte es doch gute Ergebnisse erzielen können, diese Schwächen derart einzusetzen, dass sich die daraus ergebenden Chancen zum Vorteil entwickeln können. Mitunter können Verzerrungen zu wertvollen Impulsen werden, die Diskussionen anregen, Aufmerksamkeit schärfen und die Analyse insgesamt lebendiger gestalten.

Für die Zukunft ergeben sich daraus zwei Richtungen: Zum einen braucht es eine engere Verzahnung zwischen Psychologie und IT-Sicherheit. Nur wenn die Mechanismen menschlicher Wahrnehmung systematisch berücksichtigt werden, lassen sich Threat-Modeling-Prozesse wirklich verbessern. Zum anderen sollte die Forschung stärker untersuchen, wie verschiedene Biases in realen Teams wirken. Nicht isoliert, sondern im Zusammenspiel. Gerade dieser kollektive Faktor entscheidet, ob eine Analyse engstirnig verläuft oder zu einem breiten Bild der Bedrohungslage führt.

Damit liegt im bewussten Umgang mit kognitiven Verzerrungen eine doppelte Chance: Sicherheitsanalysen werden nicht nur robuster, sondern auch praxisorientierter, weil sie die menschliche Realität der Entscheidungsfindung mit einbeziehen.

Verweise

[1] https://www.verfassungsschutz.de/SharedDocs/kurzmeldungen/DE/2025/2025-09-18-studie-bitkom.html

[2] https://www.vde.com/topics-de/health/beratung/cybersecurity-threat-modeling

[3] https://www.it-daily.net/it-sicherheit/cloud-security/psychologie-trifft-it-sicherheit

[4] https://www.isaca.org/resources/white-papers/2025/threat-modeling-revisited

[5] https://www.practical-devsecops.com/threat-modeling-best-practices/

[6] https://jums.academy/wp-content/uploads/2017/07/BA_Mantke.pdf

[7] https://www.risknet.de/themen/risknews/kognitive-verzerrungen-im-risikomanagement/