aus dem Netzwerk Insider Februar 2026

Quantencomputer bergen immenses Potenzial für neue Anwendungen und gefährden die heutige allgegenwärtige asymmetrische Verschlüsselung. Der Q-Day, an dem Quantencomputer unsere Verschlüsselung bedrohen, könnte bereits 2030 bevorstehen [1]. Doch wie werden sich Quantencomputer in unsere IT-Landschaft integrieren? Welche Anforderungen bringen sie mit sich und wie kann man sie heute schon nutzen?

Chancen durch Quantencomputer

„Quantencomputing wird die IT-Welt grundlegend verändern“ hat meine Kollegin Lea Joosten Anfang 2024 in ihrem Blog-Artikel prognostiziert [2]. Der Auslöser für diese Aussage war das beachtliche Medienecho um die Vorstellung des Google-Willow-Quantenprozessors kurz zuvor. Seitdem hat sich auf dem Feld der Quantentechnologien noch mehr getan, was auch immer wieder zu Berichten in der Fachpresse führt. Einen Einblick in die Entwicklungen haben wir auf den Treffen der IBM Quantum Community bekommen [5].

Das vergangene Jahr stand insgesamt ganz im Zeichen der Quantenphysik. Anlässlich des 100-jährigen Bestehens der Formulierung der Quantentheorie war 2025 durch die UNESCO zum internationalen Jahr der Quantenwissenschaft und Quantentechnologien ausgerufen worden [3]. Zwar besitzt Quantencomputing noch nicht die Marktreife für die breite Produktion; allerdings haben Quantencomputer durchaus das Potenzial, nach dem aktuellen KI-Hype das nächste große Ding zu werden. Nach den aktuellen Rekordinvestitionen in KI-Infrastruktur [4], könnte durch Quantencomputing die nächste große Investitionswelle in die RZ-Infrastruktur der Zukunft heranrollen.

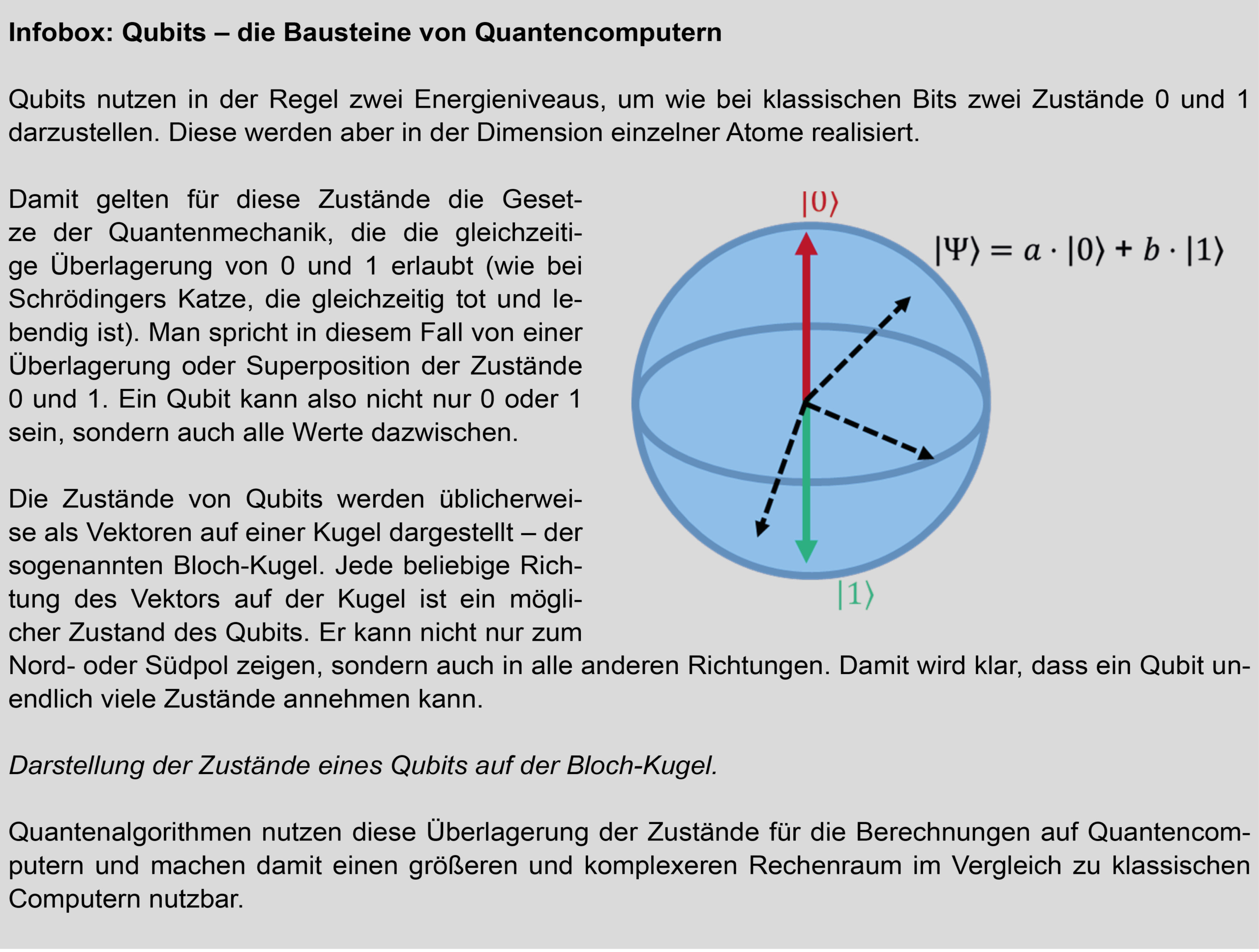

Das Geheimnis von Quantencomputern liegt dabei in ihrer grundlegend unterschiedlichen Bauweise gegenüber herkömmlichen Computern – und den damit verbundenen neuen Möglichkeiten für Berechnungen. Statt klassischer Bits, die die Zustände 0 und 1 annehmen können, verwenden Quantencomputer Quantenbits (auch Qubits genannt, siehe Infobox). Qubits können mehr als herkömmliche Bits. Sie können alle Überlagerungen von 0 und 1 gleichzeitig annehmen. Dadurch verfügen Quantenalgorithmen über eine eingebaute Parallelität. Diese Komplexität des Rechenraums lässt sich für gewisse Probleme nutzen, darunter solche, die für klassische Computer praktisch unlösbar sind. Und darin liegt das große Interesse an Quantencomputern.

Quantencomputer versprechen revolutionäre Durchbrüche in der Informationstechnologie. Sie eignen sich insbesondere dazu, die Lösung folgender Problemklassen gegenüber klassischen (Super-)Computern deutlich zu beschleunigen:

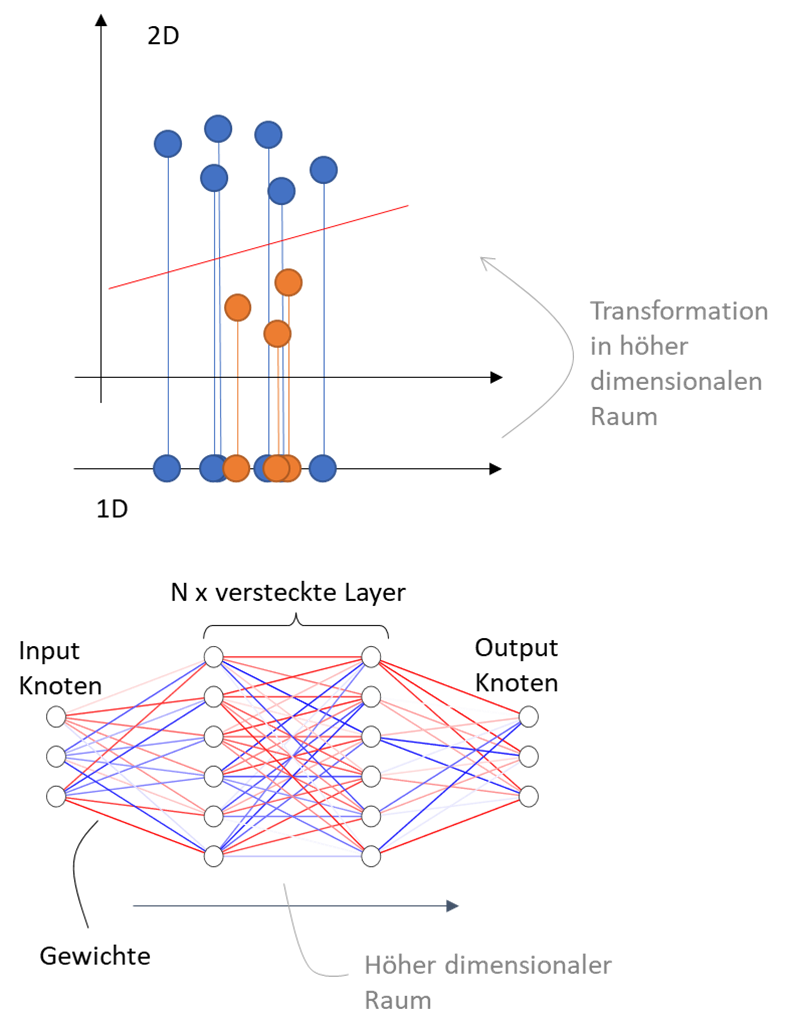

Abbildung 1: Nutzung höherdimensionaler Rechenräume bei Machine-Learning-Algorithmen. Oben: Klassifizierung mit einer Support Vector Machine. Unten: Neuronales Netz mit versteckten Lagen (Layer) von Neuronen.

- Intrinsisch quantenmechanische Probleme: Beispielsweise können Quantencomputer für Simulationen in den Materialwissenschaften wie der Erforschung von Katalysatoren, Energiespeichern, Düngern oder neuer Medikamente eingesetzt werden. Bei diesen Problemen spielen quantenmechanische Effekte in den Materialien eine wichtige Rolle, die direkt mit Quantencomputern und ohne Umwege über klassische Simulationen und Näherungen erforscht werden sollen.

- Optimierungsprobleme: Optimierungen von Abläufen und komplexen Zusammenhängen, zum Beispiel aus der Finanzbranche (z.B. Portfolio-Optimierung), in der Industrie (Produktdesign) oder in der Logistik (Lieferkettenoptimierungen) bergen großes Potenzial für Verbesserungen durch Quantencomputing. Die immense Komplexität solcher Probleme überfordert klassische Computer. Quantenalgorithmen können hier ihre eingebaute Parallelität ausnutzen, um Fortschritte gegenüber klassischen Algorithmen zu erzielen.

- Quantum Machine Learning: Die Erkennung von Strukturen in großen und komplexen Daten ist eine Kernaufgabe im Big-Data-Zeitalter. Wie bei klassischem Machine Learning werden auch in der Quantenversion dieser Algorithmen Hilfsdarstellungen in hochdimensionalen Räumen genutzt, was durch die eingebaute Parallelität und Komplexität des Rechenraums der Quantencomputer beschleunigt werden soll. Dieses Konzept findet beispielsweise bei Klassifizierungs-Problemen oder auch in der Funktionsweise neuronaler Netze Anwendung (siehe Abbildung 1).

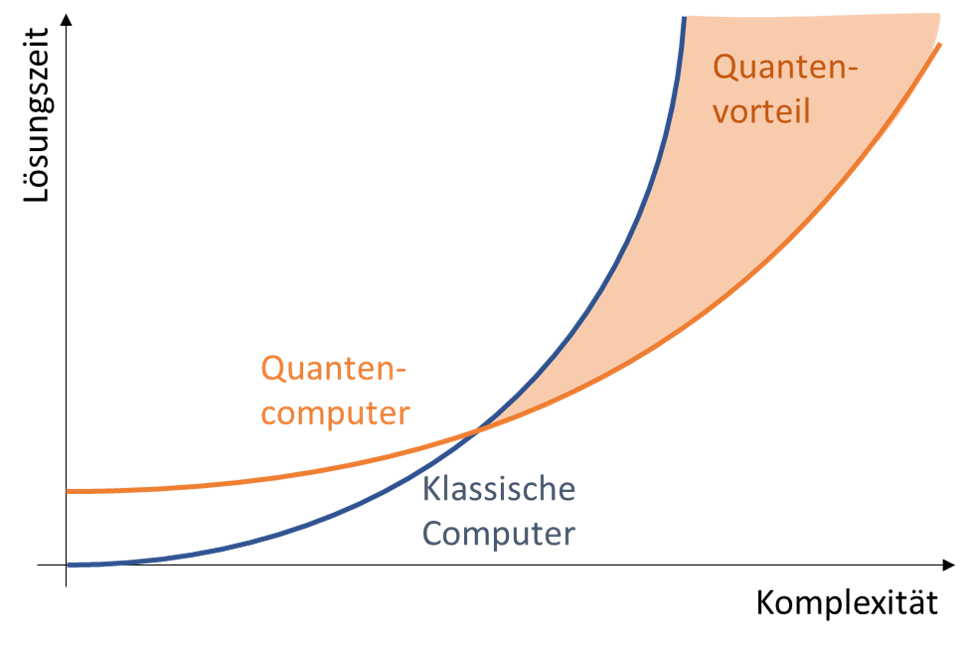

In Fällen, in denen Quantencomputer in der Lage sind, die Probleme schneller als klassische Computer zu lösen, spricht man von Quantenüberlegenheit oder Quantenvorteil. Um letzteren zu erreichen, müssen zunächst geeignete, ausreichend komplexe Probleme gewählt werden, die auf klassischen (Super-)Computern nur schwer oder gar nicht in endlicher Zeit lösbar sind. Dazu braucht es dann noch leistungsfähige Quantenalgorithmen und Quantencomputer, damit diese Probleme schneller und effizienter als ihr klassisches Gegenstück gelöst werden (siehe Abbildung 2).

Quantencomputer als Risiko für unsere Informationssicherheit

Die Angreifbarkeit kryptographischer Verfahren durch Quantencomputer ist aktuell vermutlich das am häufigsten diskutierte Anwendungsbeispiel. Gleichzeitig stellt dies die größte Gefahr dar, die von Quantencomputer für unsere klassische Informationstechnologie ausgeht. Der Q-Day, also der Tag, an dem Quantencomputer leistungsfähig genug sind, um unsere jetzigen asymmetrischen Verschlüsselungsalgorithmen zu gefährden, mahnt deshalb bereits heute zu entsprechenden Vorbereitungen. Glücklicherweise gibt es bereits Algorithmen, die auch auf klassischer Hardware ausgeführt werden können und die als quantensicher gelten [6]. Quantensicher bedeutet dabei, dass die kryptographischen Verfahren durch alternative Algorithmen ausgetauscht werden, die weder klassische Computer noch Quantencomputer leicht kompromittieren können. Man muss diese neuen Algorithmen aber heute schon einsetzen, um dem Angriffsszenario „Store now – decrypt later“<1> zuvorzukommen (siehe Abbildung 3). Das Gebot der Stunde lautet somit, kryptografische Agilität zu beweisen und die langwierige Migration zu einer Sicherheitsinfrastruktur frühzeitig anzugehen, die Post-Quanten-Kryptographie (Post Quantum Cryptography, PQC) nutzt [1].

Die allgegenwärtig genutzten asymmetrischen Verfahren der Kryptographie beruhen im Wesentlichen auf mathematischen Problemen, die sich leicht in eine Richtung lösen lassen – deren Umkehrfunktion jedoch nur sehr schwer zu berechnen ist. So ermöglicht etwa das Public-Key-Verfahren, der ganzen Welt einen öffentlichen Schlüssel zum Verschlüsseln von Nachrichten bereitzustellen, deren Entschlüsselung nur mit der Kenntnis eines passenden privaten Schlüssels möglich ist. Die durch Quantencomputer angreifbare Primfaktorzerlegung ist ein typisches Beispiel für ein solches Problem: Die Multiplikation zweier großer Primzahlen ist für klassische Computer oder sogar einfache Taschenrechner, mühelos durchzuführen. Das entstandene Produkt allerdings wieder in die einzelnen Faktoren zu zerlegen, ist für klassische Rechner praktisch unmöglich bzw. würde selbst auf Supercomputern Jahrhunderte oder Jahrtausende dauern.

Ein Quantenalgorithmus ist hier der Gamechanger. Der Shor-Algorithmus erlaubt die Primfaktorzerlegung in polynomieller Zeit. Die Lösung dieses mathematischen Problems ist somit nicht mehr unmöglich, sondern in vergleichsweise kurzer Zeit machbar. Damit wird das Prinzip hinter der asymmetrischen Verschlüsselung angreifbar. Wie oben erwähnt gibt es jedoch quantensichere (PQC-)Verschlüsselungsalgorithmen, die auch auf heutiger klassischer Hardware ausgeführt werden können. Entsprechende Hardware-Umsetzungen sind ebenfalls möglich. Zum Beispiel ist dies bei den passiven RFID-Krypto-Controllern der Fall, die im zukünftigen quantensicheren Personalausweis zum Einsatz kommen werden [7].

Abbildung 2: Der Quantenvorteil ergibt sich aus der besseren Skalierung von Quantenalgorithmen gegenüber klassischen Algorithmen bei großer Komplexität eines Problems, für das ein entsprechender Quantenalgorithmus zur Lösung existiert.

Die Existenz quantensicherer Verschlüsselungsalgorithmen verdeutlicht allerdings ebenso, dass es Probleme gibt, die sowohl für Quantencomputer als auch für klassische Computer schwer zu lösen sind. Quantencomputer werden die heutigen klassischen Rechner daher nicht ersetzen, sondern die IT-Landschaft ergänzen. Neben dem heutigen Zusammenspiel verschiedener Komponenten wie CPUs, GPUs oder dedizierter Chips auf Netzwerkkarten wird es zukünftig auch Quantenprozessoren (Quantum Processing Units, QPUs) geben. Diese dienen speziellen Problemen und arbeiten hybrid mit klassischen Computern und Beschleunigern zusammen, ohne die allgemeinen CPUs zu ersetzen.

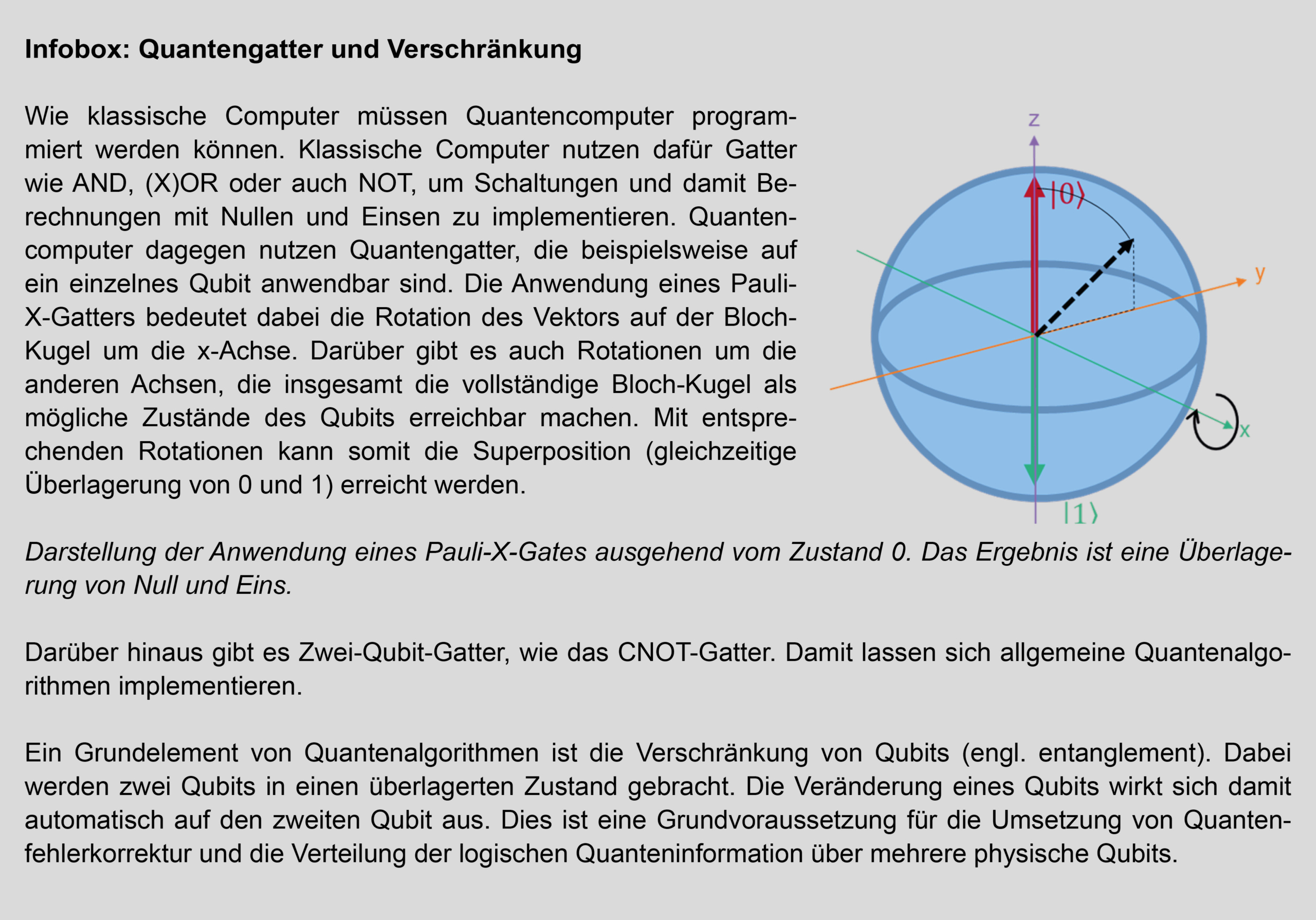

Quantencomputer der NISQ-Ära

Auch wenn in den letzten Jahren viel in Quantencomputer investiert wurde und einige Durchbrüche erreicht wurden, sind die heutigen noch nicht leistungsfähig genug, um Quantenüberlegenheit erreichen zu können. Um etwa mit dem Shor-Algorithmus die heutige asymmetrische Verschlüsselung zu gefährden, braucht es Quantencomputer, die einerseits mit einer großen Zahl von Qubits arbeiten und andererseits viele Rechenschritte mit den Qubits durchführen können. Das Ausführen von Rechenschritten bedeutet, dass Quantengatter auf die Qubits angewendet werden, um damit ihren Zustand und die Überlagerung und Verschränkung mehrerer Qubits miteinander zu beeinflussen (siehe Infobox „Quantengatter und Verschränkung“). Um Verschlüsselung mit heute typischen Schlüssellängen von 2048 Bits zu knacken, braucht es Quantencomputer mit mehr als 4.000 Qubits. Gleichzeitig müssen diese Qubits stabil genug sein, damit Rechenoperationen (Quantengatter) mit ihnen durchzuführen sind [1].

Der Shor-Algorithmus benögitgt perfekte Qubits, die es in der Realität jedoch nicht gibt. Im Gegenteil – Qubits sind notorisch instabil und fehleranfällig. Es braucht also Quantenfehlerkorrektur (Quantum Error Correction, QEC), um solche Qubits mit so geringen Fehlerraten zu erzeugen, wie typische Quantenalgorithmen es verlangen. Codes zur Fehlerkorrektur sind zwar auch aus der klassischen Welt bekannt, beispielsweise in der Datenspeicherung, bei der mit unterschiedlichen RAID-Verfahren mehrere Festplatten zur redundanten Datenspeicherung genutzt werden. In der Welt der Quanten ist dies allerdings komplizierter. Die Gesetze der Quantenphysik erlauben es nicht, perfekte und unabhängige Kopien eines Zustands zu erzeugen (No-Cloning-Theorem). Stattdessen kann man aber Verschränkung (siehe Infobox „Quantengatter und Verschränkung“) nutzen, um die logische Information, die ein Qubit trägt und verarbeitet, über mehrere physische Qubits zu verteilen. Damit wird es unwahrscheinlicher, dass ein Fehler eines physischen Qubits die verteilte Quanteninformation zerstört. Mehrere physische Qubits ergeben damit einen logischen Qubit, der fehlerkorrigiert arbeiten kann.

Abbildung 3: Darstellung der „Store now – decrypt later“-Gefährdung durch lange Migrationszeiten zu quantensicherer Krypto-Infrastruktur und der tendenziell langen Relevanz gespeicherter (verschlüsselter) Daten.

Auch wenn QEC ganz oben auf der Agenda der Hersteller von Quantencomputern steht, wird es noch einige Jahre dauern, bis es fehlerkorrigierte Quantencomputer gibt. Dennoch existieren bereits heute Quantencomputer, die trotz Fehlern in der Ausführung und Instabilitäten der Qubits produktiv genutzt werden können. Wir befinden uns aktuell in der sogenannten NISQ-Ära, der „noisy intermediate scale quantum“ Zeit. NISQ-Quantencomputer besitzen keine Fehlerkorrektur und verfügen nur über eine begrenzte Anzahl an Qubits. Diese Quantencomputer sind nicht ausschließlich im Bereich der Forschung und Entwicklung interessant. Für gewisse Probleme können ebenfalls Algorithmen mit begrenzter Tiefe auf diesen Computern ausgeführt werden. Die Menge der Anwendungsfälle von NISQ-Computern ist jedoch kleiner als bei den allgemeinen Quantencomputern der Zukunft.

Der „Quantum Approximate Optimization Algorithm“ (QAOA) ist ein Beispiel eines Quantenalgorithmus, der NISQ-freundlich ist. Gewisse Optimierungsprobleme lassen sich damit angehen. Insbesondere betrifft dies Probleme, bei denen schon eine kleine Verbesserung zum State of the Art gegenüber klassischen Computern einen Vorteil bringt. Dies kommt langsam auch in realen Anwendungen an. So wirbt IBM mit einer erfolgreichen Zusammenarbeit mit E.ON, um Abläufe im Energiehandel vorherzusagen [8]. D-Wave wiederum berichtet von einem Projekt von BASF und SAP, bei dem ein D-Wave-Quantencomputer ein Optimierungsproblem in der Auslastungsplanung von Maschinen beschleunigt [9].

NISQ-Quantencomputer sind heute schon verfügbar. Wie andere Services des klassischen Computings kann der Zugriff auf Quantencomputer aus der Cloud bezogen werden. Quantum as a Service (QaaS) ist bereits Realität – wenn auch mit begrenzten Kapazitäten. Das führt dazu, dass der Einsatz von Quantencomputern kein Schnäppchen ist – im Gegenteil. Beim Pay-as-you-go-Plan von IBM kostet eine Minute auf einem Quantencomputer fast 100 US-Dollar [10]. Die Preise bei Braket-Direct von AWS liegen je nach Modell und Bauart des zu nutzenden Quantencomputers mit 40-120 US-Dollar pro Minute in einer ähnlichen Größenordnung [11]. Mit Kosten von mehreren tausend Euro pro Stunde wird dies schnell ein teures Vergnügen.

RZ-Anforderungen durch Quantencomputer

Bereits in der NISQ-Ära finden Quantencomputer ihren Weg in Rechenzentren und werden in hybriden Szenarios in Kombination aus klassischen und Quantencomputern eingesetzt. Doch welche Anforderungen bringt ein Quantencomputer für ein Rechenzentrum mit sich? Wieviel Platz braucht ein Quantencomputer? Wieviel Strom verbraucht er und wie schwer ist er?

Um diese Fragen zu beantworten lohnt sich ein Blick in das

Datenblatt eines aktuellen Quantencomputers in der NISQ-Ära – dem Advantage2 von d-wave [12]. Der Advantage2 nutzt supraleitende Schaltkreise, um etwa 5.000 Qubits auf dem Chip zu realisieren. Diese enthalten Bauelemente, die nur bei ultrakalten Temperaturen von etwa -273°C funktionieren. Daher müssen die Quantenchips in sogenannten Kryostaten fast bis zum absoluten Temperaturnullpunkt heruntergekühlt werden. Neben Strom braucht es für diese Kühlung auch Kühlflüssigkeiten wie flüssigen Stickstoff oder Helium. Nur damit können solche extremen Temperaturen auf dem Quantenchip erlangt werden.

Kühlen allein reicht aber nicht. Die maximale elektrische Leistungsaufnahme des Advantage2 liegt bei 25 kW. Ein Teil davon geht in die Kühlung, und der Rest in den Betrieb des Quantenchips, also die Ansteuerung, Kontrolle und Messung der Qubits, die die Quantenalgorithmen umsetzen.

Ein solcher Quantencomputer hat zudem einen Platzbedarf von ca. 6 m² bei einer Höhe von 3 m und bringt knapp 4 Tonnen auf die Waage. Insgesamt braucht ein Quantenchip mit ein paar tausend Qubits heute deutlich mehr Platz und Energie als ein herkömmliches Rack in einem RZ. Warum lohnt sich so etwas trotzdem? Das liegt in der exponentiellen Skalierung der Rechenkapazitäten mit der Anzahl der Qubits im Gegensatz zur linearen Skalierung der Rechenpower mit Transistoren auf den Chips klassischer Computer.

Die Anbindung eines solchen Quantencomputers an die restliche IT-Umgebung ist dagegen mit 1000BASE-TX RJ45 Gigabit Ethernet und einer L2-Anbindung mit einem /27er IP-Adressblock keine große Herausforderung.

Da ein Quantencomputer deutlich mehr Gewicht und eine höhere Leistungsaufnahme als herkömmliche Racks mit sich bringt, sollten RZ-Planer dies bereits heute berücksichtigen. Schließlich ist die Lebenszeit von Gebäuden deutlich länger als die Lebenszeit der darinstehenden IT-Komponenten. Dies hat auch das Open Compute Project<2> erkannt und sich zum Ziel gesetzt, Erfahrungen aus heutigen Quantensystemen in offenen Standards, Best Practices und Checklisten für das Design von zukünftigen hybriden Rechenzentren zu entwickeln [13].

Die Anforderungen an die Umgebung von Quantencomputer sind dabei insgesamt höher als bei konventionellen Rechenzentren. Zwar bringen heutige KI-Rechenzentren mit ihren vielen GPUs ebenfalls neue Anforderungen mit sich, die Anforderungen durch Quantencomputer sind damit aber nicht deckungsgleich. Neben der hohen Traglast braucht die Flüssigkühlung von Quantencomputern niedrigere Temperaturen von 15°C bis 25°C. Klassische HPC-Racks, die bis zu 45°C warme Kühlkreisläufe vertragen, sind dagegen deutlich gnädiger. Auch muss die Luftfeuchtigkeit strikter kontrolliert werden, um Kondensation an den gekühlten Komponenten zu verhindern.

Da Qubits insgesamt so fehleranfällig sind, muss ebenfalls für eine entsprechende Abschirmung gegen äußere Einflüsse wie elektromagnetische Strahlung gesorgt werden. Darüber hinaus können Störungen von nahe gelegenen Funkmasten, Bahnstrecken oder durch sonstige Erschütterungen beispielsweise wegen Erdarbeiten zu Problemen im Betrieb von Quantencomputern führen. Dies kann Auswirkungen auf die RZ-Standortwahl oder die baulichen Rahmendbedingungen der RZ-Flächen der Zukunft haben.

Insgesamt sind die Standortanforderungen an hybride RZs mit Quantencomputern zwar herausfordernd, aber nicht utopisch oder unerreichbar. Es bleibt jedoch kostspielig, sodass Quantencomputer mittel- bis langfristig eine Nischenanwendung darstellen.

Zusammenfassung und Ausblick

Quantencomputer bergen großes Potenzial und werden über kurz oder lang ihren Weg in die Rechenzentren der Zukunft finden. Die Zukunft ist dabei eine diversere und hybride Computing-Landschaft, die die Stärken unterschiedlicher Architekturen wie CPUs, GPUs und dann bald auch QPUs miteinander verbindet.

Die instabile Natur der Qubits benötigt besondere Standortwahl und das bauliche Design von Rechenzentren, die Quantencomputer enthalten. Für das Rechenzentrum der Zukunft, das morgen oder übermorgen geplant wird, müssen diese Anforderungen schon heute auf der Agenda landen. Anderenfalls muss möglicherweise schon bald neu gebaut werden.

Quellen und Verweise

[1] Bundesamt für Sicherheit in der Informationstechnik, „Studie: Entwicklungsstand Quantencomputer Version 2.2“, 19.12.2025. Abrufbar unter https://www.bsi.bund.de/SharedDocs/Downloads/DE/BSI/Publikationen/Studien/Quantencomputer/Entwicklungstand_QC_V_2_2.html?nn=916616

[2] Lea Joosten, „Quantencomputing wird die IT-Welt grundlegend verändern“, ComConsult Blog,14.01.2025. Abrufbar unter https://www.comconsult.com/quantencomputing-wird-die-it-welt-grundlegend-veraendern/

[3] Deutsche UNESCO-Kommission e. V., 01.01.-31.12.2025 – Internationales Jahr der Quantenwissenschaft und Quantentechnologien, Abrufbar unter https://www.unesco.de/aktuelles/internationales-jahr-der-quantenwissenschaft-und-quantentechnologien/

[4] Dr. Philipp Rüßmann, „Rekordinvestitionen in Rechenzentren durch den KI-Hype“, ComConsult Blog, 04.02.2025. Abrufbar unter https://www.comconsult.com/rekordinvestitionen-in-rechenzentren-durc.h-den-ki-hype/

[5] Dr. Philipp Rüßmann, „Mit Riesenschritten auf dem Weg zum Q-Day“, ComConsult Blog, 10.07.2025. Abrufbar unter https://www.comconsult.com/mit-riesenschritten-auf-dem-weg-zum-q-day/

[6] Dr. Behrooz Moayeri, „PQC-Algorithmen veröffentlicht“, ComConsult Blog, 03.12.2024. Abrufbar unter https://www.comconsult.com/pqc-algorithmen-veroeffentlicht/

[7] Felix Horn, „Gefährdet der Q-Day unsere Identität?“, ComConsult Blog 08.12.2025. Abrufbar unter https://www.comconsult.com/gefaehrdet-der-q-day-unsere-identitaet/

[8] IBM Quantum, „E.ON uses quantum computing to help tackle complexity“. Abrufbar unter https://www.ibm.com/case-studies/eon

[9] Abhishek Awasthi, Nico Kraus, Florian Krellner und David Zambrano, „Real World Application of Quantum-Classical Optimization for Production Scheduling“, 03.08.2024. Abrufbar unter https://arxiv.org/pdf/2408.01641

[10] IBM Quantum, „Preise Pay-As-You-Go Plan“, 05.01.2026. Abrufbar unter https://www.ibm.com/quantum/products

[11] AWS braket, „Preise Braket Direct“, 05.01.2026. Abrufbar unter https://aws.amazon.com/de/braket/pricing/

[12] D-Wave, „Datenblatt Advantage2“. Abrufbar unter https://www.dwavequantum.com/media/htjclcey/advantage_datasheet_v10.pdf

[13] The Register, „Open Compute Project figuring out how to get quantum computers into classical datacenters”, 21.11.2025. Abrufbar unter https://www.theregister.com/2025/11/21/ocp_hpc_quantum_datacenter_integration/

<1> Verschlüsselte Daten von heute können jetzt abgefangen und gespeichert werden. Das Ziel der Angreifer ist, diese Daten in der Zukunft mit leistungsfähigen Quantencomputern zu entschlüsseln.

<2> Das Open Compute Project (OCP) ist eine Organisation, die den Austausch und die Entwicklung offener Standards für das Design von Komponenten für Rechenzentren vorantreibt. Zu den Mitgliedern des OCP gehören Branchengrößen wie Arm, Meta, IBM, Intel, Google, Microsoft, Dell, NVIDIA, Cisco, oder die Alibaba Group.